• 11/2025 • Seite 20 • DPG-Mitglieder

• 11/2025 • Seite 20 • DPG-MitgliederDas Wasserstoffatom der starken Wechselwirkung

Die ATLAS- und CMS-Kollaborationen am LHC haben starke Hinweise auf Toponium gefunden.

• 11/2025 • Seite 20 • DPG-Mitglieder

• 11/2025 • Seite 20 • DPG-MitgliederDie ATLAS- und CMS-Kollaborationen am LHC haben starke Hinweise auf Toponium gefunden.

• 9/2025 • Seite 69 • DPG-Mitglieder

• 9/2025 • Seite 69 • DPG-MitgliederKomplexe Interferenzmuster könnten die Existenz zusätzlicher Higgs-Bosonen zeigen.

Die Entdeckung eines Higgs-Bosons am Large Hadron Collider hat 2012 eindrucksvoll belegt, dass das Vakuum nicht leer ist: Das allgegenwärtige Higgs-Feld verleiht den bisher bekannten Elementarteilchen ihre Masse. Die Struktur des Vakuums könnte aber durch zusätzliche Higgs-Felder bzw. -Bosonen noch deutlich komplexer sein. Diese erklären vielleicht die Natur der Dunklen Materie oder den bisher ungeklärten Ursprung des Überschusses von Materie gegenüber Antimaterie und könnten sich als komplexe Interferenzmuster zeigen. Nun liegen die experimentellen und statistischen Grundlagen vor, um diese zu entdecken [1].

Am 4. Juli 2012 haben die ATLAS- und CMS-Kollaborationen die Entdeckung eines Higgs-Bosons am Large Hadron Collider des CERN bekannt gegeben: ein Meilenstein der Elementarteilchenphysik [2, 3]. Etwa 40 Jahre nach seiner Vorhersage war der Nachweis des Feldes geglückt, das den bekannten Elementarteilchen ihre Masse verleiht. Dieses Higgs-Feld durchdringt das Vakuum und ist auch dann noch vorhanden, wenn alle anderen Teilchen und Felder fehlen. Das Higgs-Feld ist also untrennbar mit dem Vakuum unseres Universums verbunden. Das 2012 entdeckte Higgs-Boson ist eine Anregung dieses Feldes, die nur hochenergetische Teilchenkollisionen ermöglichen, wie sie am LHC stattfinden.

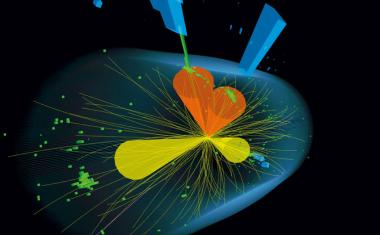

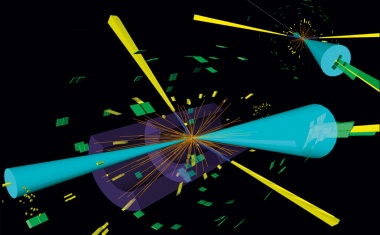

Die kurzlebigen Higgs-Bosonen zerfallen praktisch instantan in leichtere Teilchen des Standardmodells. Im Detektor lassen sich Zerfälle in zwei hochenergetische Photonen besonders gut identifizieren. (...)

Das CERN veröffentlicht einen Bericht über die Durchführbarkeit eines möglichen Future Circular Collider.

• 9/2023 • Seite 65 • DPG-Mitglieder

• 9/2023 • Seite 65 • DPG-MitgliederPrecise and fine-grained measurements of the Higgs boson are continuously improved.

The Large Hadron Collider is a 27 km-long circular particle collider which has been in operation since 2010 at CERN. At the Large Hadron Collider, protons collide at a record-breaking centre-of-mass energy of up to 13.6 TeV. Four large experiments are placed around the ring at the intersection points of the proton beams: ATLAS, CMS, LHCb, and ALICE detect the products of the resulting collisions. The study of these data helps to improve our understanding of the universe.

In July 2012, the ATLAS and CMS collaborations announced the discovery of a new particle with a mass of around 125 GeV/c2 [1 – 3]: the Higgs boson, a particle predicted in the 1960s which is responsible for generating the masses of other elementary particles. The Standard Model of particle physics describes the building blocks of everything around us. Matter consists of fermions: quarks and leptons which exist in three generations. The interactions between these particles are mediated by ‚force carriers‘: the bosons. The discovery of the Higgs boson completed a major missing piece of the Standard Model.

One of the reasons, it took nearly half a century to find the Higgs boson is that its mass was not predicted by the Standard Model. Therefore, physicists had to search a wide range of masses. Furthermore, the Higgs boson can decay to a range of other elementary particles – and the rate of a particular decay channel depends on the mass of the Higgs boson. Thus, many different final states had to be investigated. With a mass of 125 GeV/c2, the Higgs boson might decay into pairs of bosons (WW, ZZ, γγ) or pairs of fermions such as bottom quarks and tau leptons. In addition to a range of decay channels, there are several ways to produce the Higgs boson at the Large Hadron Collider (LHC): the dominant production mechanism with 87 % is the fusion of two gluons, followed by the fusion of vector bosons (W or Z boson), the production in association with a vector boson, and with a pair of top quarks. (...)

• 3/2023 • Seite 45 • DPG-Mitglieder

• 3/2023 • Seite 45 • DPG-MitgliederIm Jahr 2029 soll die Luminosität des Large Hadron Collider durch ein weiteres signifikantes Upgrade deutlich steigen.

Der Large Hadron Collider (LHC) ist derzeit der weltweit größte und leistungsstärkste Teilchenbeschleuniger der Welt. Er befindet sich in einem ringförmigen Tunnel mit knapp 27 Kilometern Umfang am CERN bei Genf. Der Tunnel stammt aus den 1980er-Jahren; von 1989 bis 2000 war dort der Large Electron-Positron Collider in Betrieb [1].

Zwei Größen bestimmen im Wesentlichen die Leistungsfähigkeit eines Beschleunigers für die Hochenergiephysik: die erreichbare Kollisionsenergie und die Luminosität – ein Wert, der angibt, wie viele Kollisionen pro Fläche und Zeit auftreten können. Die Inbetriebnahme des Large Hadron Collider (Abb. 1) begann Ende 2009 mit einer Strahlenergie von 450 GeV. Mit dieser Injektionsenergie füllt das Super Proton Synchrotron (SPS) den LHC mit Protonenpaketen. Diese bewegen sich im Tunnel in umgekehrter Richtung in zwei Ringen, die einen Abstand von 19,4 Zentimetern besitzen (Abb. 2). An vier Kreuzungspunkten können die Teilchen nahezu frontal aufeinanderstoßen, wobei die doppelte Strahlenergie als Kollisionsenergie erreicht wird. Im März 2010 kollidierten am LHC Protonenstrahlen mit 2 × 3,5 TeV = 7 TeV, was den bisherigen Rekord von 1,96 TeV, aufgestellt am Tevatron des Fermilab (Illinois, USA), deutlich übertraf.

Danach schritt am LHC die Leistungsfähigkeit schnell voran [2]: Für die höhere Luminosität sorgten mehr Teilchenpakete in den Ringen und kleinere Strahlgrößen an den Kreuzungspunkten. Das Tevatron stellte am 30. September 2011 den Betrieb ein; zu diesem Zeitpunkt lieferte der LHC bereits fast zehnmal mehr Luminosität als das Tevatron. Die erfolgreiche Beschleunigerentwicklung am LHC krönten die beiden großen Experimente ATLAS und CMS am 4. Juli 2012 durch den experimentellen Nachweis des Higgs-Bosons. (...)

• 10/2022 • Seite 27 • DPG-Mitglieder

• 10/2022 • Seite 27 • DPG-MitgliederUnter Einsatz neuer Analysemethoden ist der Nachweis seltener Ereignisse der Vektorboson-Streuung am Large Hadron Collider gelungen.

Wenn die Eichbosonen des Standardmodells der Teilchenphysik miteinander wechselwirken, könnten sich dabei Hinweise auf Physik jenseits der etablierten Theorie zeigen. Nun ist es mithilfe neuer Methoden bei der Datenanalyse erstmals gelungen, die Wechselwirkung zwischen vier Eichbosonen am Large Hadron Collider zu beobachten: die Vektorboson-Streuung. Dieser Meilenstein erlaubt es, den Higgs-Mechanismus tiefergehend zu verstehen.

unser gesamtes gegenwärtiges Wissen über Elementarteilchen und deren Wechselwirkungen. Mathematisch als Quantenfeldtheorie formuliert, macht es sehr konkrete Vorhersagen, die sich experimentell überprüfen lassen. Das Konstruktionsprinzip dieser erfolgreichen Theorie basiert auf Eichsymmetrien. Diese beschreiben die Wechselwirkung zwischen Elementarteilchen durch den Austausch zugehöriger Eichbosonen, die mit einer gewissen Stärke aneinander koppeln. Eichbosonen sind selbst Elementarteilchen mit einem Spin von 1; sie heißen daher auch Vektorbosonen. Als Beispiel beschreibt der Austausch von Photonen die elektromagnetische Wechselwirkung zwischen elektrisch geladenen Teilchen.

Die Forderung von Symmetrien schränkt die Theorie jedoch stark ein. So verbietet sie zunächst jegliche Massen für die Austauschteilchen der Wechselwirkungen − ein wortwörtlich massives Problem bei der Formulierung des Standardmodells in den 1950er- und 1960er-Jahren. Erst die Einführung eines neuen Quantenfeldes, des Higgs-Feldes, ermöglichte massive Austauschteilchen. Im mathematisch-theoretischen Jargon bricht das Higgs-Feld die Symmetrie spontan. Dieser mathematische Trick erlaubte es, die Existenz massiver Vektorbosonen konsistent in das Modell zu integrieren. Die Prozedur ist als Higgs-Mechanismus bekannt und sagt ein Teilchen ohne Spin vorher: das Higgs-Boson. Vor zehn Jahren gelang es am Large Hadron Collider, dieses nachzuweisen; im Jahr darauf erhielten Peter Higgs und François Englert für ihre Vorhersage den Physik-Nobelpreis. (...)

• 6/2022 • Seite 29 • DPG-Mitglieder

• 6/2022 • Seite 29 • DPG-MitgliederAm Large Hadron Collider lassen sich Top-Quarks mit bisher unerreichter Präzision erforschen und damit wegweisende Erkenntnisse für die Teilchenphysik gewinnen.

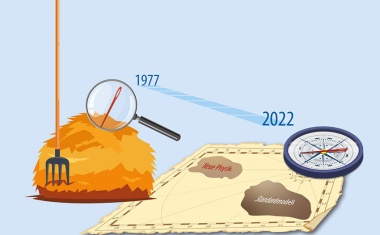

Ein Vierteljahrhundert nach der Entdeckung des Top-Quarks am Tevatron-Beschleuniger des Fermilab öffnet der Large Hadron Collider am CERN die Tür zu einem neuen Bereich der Teilchenphysik. Entsprach der Weg zur Entdeckung noch der sprichwörtlichen Suche nach der Nadel im Heuhaufen, produziert der LHC heute Top-Quarks millionenfach. Die damit erreichbare Genauigkeit erlaubt nicht nur detaillierte Tests des Standardmodells der Teilchenphysik, sondern kann auch den Weg zu seinen möglichen Erweiterungen weisen.

Das Top-Quark spielt im Standardmodell der Teilchenphysik eine besondere Rolle. In den 1970er-Jahren zeigte sich, dass Fermionen (Teilchen mit halbzahligem intrinsischen Drehimpuls) in Familien auftreten, von denen jede aus zwei Quarks, einem geladenen Lepton und einem Neutrino besteht. Diese Familien unterscheiden sich nur durch die Massen der enthaltenen Fermionen. Anfangs waren nur zwei Familien bekannt: Zur ersten Familie gehören u- und d-Quark, Elektron und Elektron-Neutrino, zur zweiten c- und s-Quark, Myon und Myon-Neutrino. Die Entdeckung des τ-Leptons 1975 und des b-Quarks 1977 lieferten jedoch Hinweise auf eine dritte, schwerere Familie. Zu diesem Zeitpunkt fehlte ihr zugehöriges Neutrino sowie ein zweites Quark, das Top-Quark. Obwohl das Standardmodell außer der Masse alle Teilchen-Eigenschaften vorhersagt, führten die intensiven Suchen erst nach fast zwanzig Jahren zum Nachweis des Top-Quarks. Seine für subatomare Verhältnisse riesige Masse – es ist fast 35-mal schwerer als ein b-Quark und damit fast so schwer wie ein Goldatom – macht das Top-Quark einzigartig und stellte die damaligen Experimente vor große Herausforderungen. (...)

• 10/2021 • Seite 42 • DPG-Mitglieder

• 10/2021 • Seite 42 • DPG-MitgliederNach der Entdeckung des Higgs-Bosons geht es nun darum, seine Eigenschaften präzise zu bestimmen und so Hinweise auf neue Physik zu suchen.

Mehr als neun Jahre und zwei Messkampagnen liegt die Entdeckung eines Higgs-Bosons am Large Hadron Collider des CERN zurück. Inzwischen hat sich ein Fünfzehnfaches der Datenmenge von damals angesammelt, und die Schwerpunktsenergie des Beschleunigers wurde von 8 auf 13 TeV gesteigert. Dies ermöglichte es, wissenschaftliches Neuland zu betreten und das Higgs-Boson systematisch zu erforschen. Viele seiner Eigenschaften wurden präzise gemessen. So ist es möglich, Hinweise auf neue Physik zu erhalten, selbst wenn diese zunächst nicht direkt beobachtbar sein sollte.

Der Brout-Englert-Higgs-Mechanismus löst ein fundamentales Problem des Standardmodells der Teilchenphysik. Diese moderne Quantenfeldtheorie erklärt und beschreibt alle fundamentalen Wechselwirkungen aller bekannten Teilchen untereinander – mit Ausnahme der Gravitation. Die Wechselwirkungen erfolgen über Vermittlerteilchen: das Photon (γ) im Fall der Elektro dynamik, die W- und Z-Bosonen für die schwache Kraft und die Gluonen (g) im Fall der starken Kraft. Die Existenz, Dynamik und nahezu alle Eigenschaften dieser Vermittlerteilchen lassen sich aus der Forderung lokaler Eichsymmetrien, wie sie aus der Elektrodynamik bekannt sind, ableiten [1]. Eichtheorien haben aber eine Schwäche:

Sie erfordern zwingend, dass alle Vermittlerteilchen masselos sein müssen, da ein von Null verschiedener Massenterm die Eichsymmetrie zerstört. Diese Forderung steht jedoch in eklatantem Widerspruch zu den experimentell nachgewiesenen hohen Massen der W- und Z-Bosonen. Einen Ausweg aus diesem Dilemma bietet die spontane Symmetriebrechung.

Dabei besitzt das physikalische System zwar alle erforderlichen Symmetrien. Allerdings erscheinen die Eichsymmetrien im energetischen Grundzustand der Natur – dem Vakuum – teilweise gebrochen, wodurch die W- und Z-Bosonen dynamisch eine Masse erhalten [2, 3].

Dieser Mechanismus sagt die Existenz eines neuen fundamentalen Teilchens vorher: das Higgs-Boson. Dieses entsteht aus der Quantisierung und Anregung eines postulierten Higgs-Feldes im Vakuum. Es ist das einzige bekannte Elementarteilchen ohne Spin und wechselwirkt mit allen bekannten Teilchen des Standardmodells – bei Fermionen proportional zu deren Masse, bei Bosonen mit dem Quadrat der Masse. Die Masse des Higgs-Bosons sagt das Standardmodell jedoch nicht vorher. Lange nach seiner Postulierung 1964 [3] galt das Teilchen als unmessbar. Doch 2012 wurde ein neues Teilchen mit genau den erwarteten Eigenschaften entdeckt [4]. (...)

• 10/2018 • Seite 35

• 10/2018 • Seite 35Mit seltenen Zerfällen lässt sich nach Teilchen suchen, die das Standardmodell nicht beschreibt.

Die Suche nach neuer Physik jenseits des Standardmodells der Teilchenphysik ist zentrales Ziel der aktuellen Forschung. Das präzise Vermessen seltener Zerfälle erlaubt es, die Effekte neuer Teilchen nachzuweisen, selbst wenn sich diese aufgrund ihrer hohen Masse an derzeitigen Beschleunigern nicht direkt erzeugen lassen.

Wir haben einen Meilenstein in unserem Verständnis der Natur erreicht“, so kommentierte der damalige CERN-Generaldirektor Rolf-Dieter Heuer die Entdeckung des Higgs-Bosons im Jahr 2012. Ganz zu Recht, denn schließlich war damit das letzte fundamentale Teilchen des Standardmodells der Teilchenphysik gefunden. Unerwartet war diese Entdeckung allerdings nicht: Aus Präzisionsmessungen der Parameter der elektroschwachen Wechselwirkung, beispielsweise der Massen der W- und Z-Bosonen, ließ sich schon vor der Entdeckung die Masse des Higgs-Bosons im Standardmodell auf weniger als etwa 150 GeV beschränken. In der Tat zeigte sich die zugehörige Signatur im erwarteten Bereich bei 125 GeV.

Dies zeigt sehr anschaulich den typischen Ablauf von Entdeckungen in der Teilchenphysik: Neue Teilchen rufen in Präzisionsmessungen Effekte hervor, die nicht mit den bis dahin bekannten Teilchen zu erklären sind. Hinweise aus Präzisionsmessungen gehen im Allgemeinen den direkten Entdeckungen bis dahin unbekannter neuer Teilchen voraus. Wichtige weitere historische Beispiele sind die Entdeckung des Charm-Quarks, das nach Messungen seltener Kaon-Zerfälle vorhergesagt wurde, die Existenz einer dritten Generation von Quarks, die auf der Entdeckung der Verletzung der Materie-Antimaterie-Symmetrie in der schwachen Wechselwirkung beruht, sowie die genaue Vorhersage der Masse des Top-Quarks...

• 9/2015 • Seite 35

• 9/2015 • Seite 35Im Juli 2012 gaben die Experimente ATLAS und CMS die Entdeckung des Higgs-Bosons bekannt. Was wissen wir heute über die Eigenschaften dieses Teilchens?

Während der vergangenen Jahre haben Physiker der beiden Experimente ATLAS und CMS am Large Hadron Collider (LHC) den kompletten zwischen 2010 und 2012 aufgezeichneten Datensatz ausgewertet. Dies ermöglichte es, wichtige Eigenschaften des Higgs-Bosons zu bestimmen und ihre Übereinstimmung mit den Vorhersagen des Standardmodells der Teilchenphysik zu überprüfen. Passt das neue Teilchen in das Standardmodell oder zeigt es exotische, abweichende Eigenschaften? So sagen Erweiterungen z. B. nicht-elementare, zusammengesetzte oder zusätzliche Higgs-Bosonen vorher.

Das Standardmodell der Teilchenphysik enthält Quarks und Leptonen als fundamentale Fermionen mit Spin 1/2. Sie bilden die Bausteine der Materie. Wechselwirkungen zwischen ihnen werden durch den Austausch von Bosonen mit Spin 1, so genannten Vektorbosonen, vermittelt. Diese ebenfalls elementaren Teilchen sind das Photon für die elektromagnetische Wechselwirkung, die W- und Z-Bosonen für die schwache Wechselwirkung und Gluonen für die starke Wechselwirkung. Um die experimentell beobachteten Massen der W- und Z-Bosonen zu erklären, enthält das Standardmodell einen in den 1960er-Jahren von Brout, Englert und Higgs sowie von Guralnik, Hagen und Kibble etablierten Mechanismus [1]. Er geht von der Existenz eines skalaren Feldes aus, des Higgs-Feldes, welches das gesamte Vakuum durchdringt. Die Massen der W- und Z-Bosonen sowie der Fermionen ergeben sich durch ihre Wechselwirkung mit diesem Feld. Mit der Existenz des skalaren Feldes ist ein Teilchen mit Spin 0, das Higgs-Boson, verbunden. Der Brout-Englert-Higgs-Mechanismus bildet einen zentralen Stützpfeiler des Standardmodells, da er theoretisch konsistent erklärt, wie Elementarteilchen ihre Masse erhalten. Daher beschäftigte die Suche nach diesem Teilchen über Dekaden die Teilchenphysik, und seine Entdeckung im Jahr 2012 war ein Meilenstein [2].

Die Analyse der gesamten von den Detektoren ATLAS und CMS aufgezeichneten Daten (Abb. 1, 2) ermöglichte es, das „Profil“ des neuen Bosons bereits überraschend gut zu bestimmen. Dazu haben auf experimenteller Seite neben der großen Datenmenge auch verbesserte Analysemethoden und eine verbesserte Kalibration der Detektoren beigetragen. Darüber hinaus sind präzise Berechnungen, z. B. der Produktionsraten, für den Vergleich mit den Vorhersagen des Standardmodells wichtig. ...

• 9/2015 • Seite 18

• 9/2015 • Seite 18Die Experimente CMS und LHCb entdecken einen seltenen Zerfall von B-Mesonen.

• 1/2014 • Seite 23

• 1/2014 • Seite 23Eine musikalische Reise durch den Large Hadron Collider.

„Have you ever heard about the Higgs Boson blues? I‘m goin‘ down to Geneva baby, gonna teach it to you“, singt Nick Cave mit rauem Timbre zu den schleppenden Klängen seiner Band Bad Seeds. Dem australischen Musiker geht es jedoch nicht um harte Physik, vielmehr verknüpft er im Liedtext kurzerhand das „Gottesteilchen“ mit der Geschichte vom Teufelspakt des Bluesmusikers Robert Johnson. Aber haben die Forscherinnen und Forscher am CERN vielleicht Gründe für einen Higgs-Boson-Blues? Das vor einem halben Jahrhundert postulierte Teilchen ist schließlich entdeckt, der Nobelpreis an seine theoretischen Väter verliehen, und der Large Hadron Collider ist in einen fast zweijährigen Dornröschenschlaf versunken.

Ein ausgeschalteter Beschleuniger hat aber nichts mit Stillstand zu tun. Nicht umsonst lautet das Motto des CERN: „Accelerating Science“ und nicht „Finding the Higgs“. In der Betriebspause gilt es, den Upgrade der „Weltmaschine“ auf die Kollisionsenergie von 14 Teraelektronenvolt zu leisten. Bei dieser Energie hoffen die Forscher, mit dem LHC noch genauer auf das entdeckte Higgs-Boson oder noch tiefer in die „Quark-Gluon-Suppe“ des Protons blicken zu können. Doch dafür ist eine Herkulesaufgabe zu stemmen: Sie müssen mehr als zehntausend Hochstrom-Verbindungen zwischen den supraleitenden Beschleunigermagneten im 27 Kilometer langen Tunnel verstärken. Dabei ist höchste Sorgfalt gefordert, war es doch eine fehlerhafte Verbindung zwischen den Magneten, die den LHC im Herbst 2008 für mehr als ein Jahr lahmgelegt hatte. Die Auswertung der riesigen Datenmengen geht derweil weiter, und schon seit geraumer Zeit denkt die Teilchenphysik-Community über den nächsten und übernächsten Upgrade des LHC nach. Für eine um den Faktor fünf bis zehn höhere Kollisionsrate ab 2020 ist jedoch noch viel Entwicklungsarbeit nötig.

Der Schriftsteller Hans Magnus Enzensberger nannte das CERN einmal „Kathedrale der Wissenschaft“, nicht nur wegen der Ausmaße, sondern auch, weil so viele Beteiligte für Projekte arbeiten, die erst nach Jahren Früchte tragen. Diese Kathedrale ist meist vom profanen Krach der Generatoren, Kompressoren und Pumpen erfüllt, hat aber auch Musik zu bieten. ...

• 12/2013 • Seite 24

• 12/2013 • Seite 24Für die Entdeckung eines Mechanismus‘ zur Massenerzeugung erhalten François Englert und Peter Higgs den Physik-Nobelpreis 2013.

Die Entdeckung des Higgs-Teilchens ist der bisherige Höhepunkt des vielleicht größten und langfristigsten Projekts der Grundlagenforschung. Es begann mit Enrico Fermi und seinem „Versuch einer Theorie der β-Strahlen“ 1934. Als großes strukturelles Problem dieser Theorie der schwachen Kernkraft stellte sich im Laufe der Jahrzehnte die Tatsache heraus, dass die nach ihm benannte Fermi-Kopplungskonstante nicht einfach eine Zahl ist, sondern die Einheit von 1/Masse2 hat.

Ein Jahr später stellte Hideki Yukawa die grundlegende Verbindung dieses Problems mit dem Higgs-Mechanismus und der Masse von Teilchen her mit seiner Arbeit „On the interaction of elementary particles“: Die schwache Kernkraft hat nur eine kurze Reichweite, die sich mit Hilfe von massiven Austauschteilchen erklären lässt, die wiederum für eine Kopplungskonstante mit Einheit 1/Masse2 verantwortlich sind. In diesem Sinne ist der Higgs-Mechanismus nicht in erster Linie für die Masse zum Beispiel des Tisches, auf dem dieser Artikel geschrieben wird, verantwortlich, sondern für die Größe von Atomkernen.

Mit masselosen Austauschteilchen beschäftigten sich seit den 1920er-Jahren viele Physiker. 1942 schlug Sin-Itiro Tomonaga eine mathematisch umfassend verstandene Quantentheorie der elektrischen Ladung, die Quantenelektrodynamik, vor. Unabhängig davon entwickelte Julian Schwinger 1948 dieselbe Theorie. Sowohl Fermis Theorie als auch die Quantenelektrodynamik waren experimentell außerordentlich erfolgreich, und aus heutiger Sicht war die offensichtliche Frage lediglich, wie man eine Version der Quantenelektrodynamik mit massiven Austauschteilchen konstruieren kann, um aus Fermis Theorie der schwachen Kermkräfte eine moderne Quantentheorie zu machen. Tatsächlich versuchte sich Sheldon Glashow, ein Student von Schwinger, im Jahr 1961 noch ohne durchschlagenden Erfolg an diesem Problem.

Zu diesem Zeitpunkt betreten Peter Higgs, Robert Brout und François Englert die Bühne. Die grundlegende Idee hinter dem Higgs-Mechanismus oder allgemeiner der sog. spontanen Symmetriebrechung ist sehr einfach: Wenn man zum Beispiel die Energieniveaus im Wasserstoffatom betrachtet, dann gibt es viele verschiedene Elektronenzustände mit identischen Energien, weil das Atom unter Rotationen im Raum symmetrisch ist. Bricht man diese Symmetrie von außen, zum Beispiel mit Hilfe eines starken Magnetfelds, so spalten diese Energieniveaus auf. Bei der spontanen Symmetriebrechung hingegen bricht in einem physikalischen System nicht eine bestimmte Wechselwirkung die Symmetrie; das System nimmt aus welchem Grund auch immer einen Zustand an, der eben nicht symmetrisch ist. Der Higgs-Mechanismus geht noch einen Schritt weiter, indem er postuliert, dass das ganze Universum in einem nicht symmetrischen Vakuum-Zustand existiert, von dem wir aber nicht wissen, wie und warum dieser zustande gekommen ist. Wenn eine symmetrische Welt nur masselose Teilchen erlaubt, dann haben diese Teilchen in einer gebrochen symmetrischen Welt Massen. Kurz nach dem Urknall mag das Vakuum noch symmetrisch gewesen sein, aber heute sehen wir nur eine reduzierte Symmetriestruktur mit massiven Austauschteilchen der schwachen Kernkraft. ...

• 9/2012 • Seite 18

• 9/2012 • Seite 18Die Experimente ATLAS und CMS am LHC entdecken ein neues Teilchen mit einer Masse von 126 GeV/c2.

• 4/2012 • Seite 55

• 4/2012 • Seite 55Erste Ergebnisse der direkten Suchen nach neuen Teilchen am Large Hadron Collider

Ein zentrales Motiv für den Bau des LHC war die Suche nach neuen Elementarteilchen und Wechselwirkungen. Dazu zählen insbesondere das Higgs-Boson, der letzte fehlende Baustein des Standardmodells, sowie Teilchen, die von supersymmetrischen Erweiterungen des Standardmodells vorhergesagt werden.

Zu den ungeklärten Rätseln der Teilchenphysik gehört die Frage nach dem Ursprung der Masse der Elementarteilchen. Obwohl die mathematische Struktur des Standardmodells eigentlich nur masselose Teilchen vorsieht, haben z. B. die Austauschteilchen der schwachen Wechselwirkung, die W+-, W–- und Z0-Bosonen, eine Masse von 80 beziehungsweise 91 GeV/c2. Das Standardmodell beruht auf der Hypothese, dass der sog. Higgs-Mechanismus Teilchen ihre Masse verleiht. Dieser Mechanismus sagt außerdem ein neues Teilchen voraus, das Higgs-Boson. Die experimentelle Suche nach diesem entscheidenden fehlenden Baustein im Mosaik des Standardmodells ist zentral für das Forschungsprogramm des LHC.

Das zweite ungeklärte Rätsel ist die Frage, was jenseits des Standardmodells kommt. Bisher beschreibt das Standardmodell alle beobachteten Wechselwirkungen der Elementarteilchen, eine durchaus bemerkenswerte wissenschaftliche Errungenschaft. Von einer fundamentalen Theorie der Natur ist es jedoch noch weit entfernt, denn die Liste seiner unerklärten Eigenschaften ist recht lang: Auffällig ist zunächst seine Struktur mit drei fundamentalen Kräften und mit drei Generationen von Leptonen und Quarks. Weder für diese Struktur noch für die damit verbundenen Zahlenwerte der Naturkonstanten (Massen, Kopplungskonstanten, ...) gibt es im Standardmodell eine Erklärung. Auch ist fraglich, ob diese Theorie bei sehr hohen Energien gültig sein kann, denn hierfür müssten einige Parameter sehr präzise Werte annehmen. Eine solche Feinjustierung – auch als Hierarchieproblem bekannt – gilt vielen Physikern als unnatürlich. Zudem ist es bisher nicht gelungen, das Standardmodell mit der Gravitation in einer gemeinsamen Theorie zu verknüpfen. Eine Erklärung für die Beobachtung Dunkler Materie und Dunkler Energie im Universum fehlt ebenfalls. Diese Mängelliste ließe sich noch fortsetzen.

Aus diesen Gründen wurde in den letzten Jahrzehnten eine Vielzahl von Erweiterungen des Standardmodells vorgeschlagen. Der prominenteste Kandidat ist die Supersymmetrie. Im Gegensatz zum Standardmodell, in dem alle Materieteilchen Fermionen mit Spin ½ sind und Bosonen mit Spin 1 alle Kräfte vermitteln, basiert Supersymmetrie auf dem Postulat einer Symmetrie zwischen Fermionen und Bosonen. Die damit vorhergesagten neuen Teilchen können jedoch viel schwerer als ihre Partner im Standardmodell sein, sodass sie in bisherigen Experimenten nicht zu entdecken waren. Falls das leichteste supersymmetrische Teilchen stabil ist, würde sich damit auch direkt die Existenz Dunkler Materie erklären lassen. ...

• 4/2012 • Seite 37

• 4/2012 • Seite 37In internationalen Kollaborationen entwickelt und aufgebaut, zeichnen die Detektoren die komplexen Reaktionen auf.

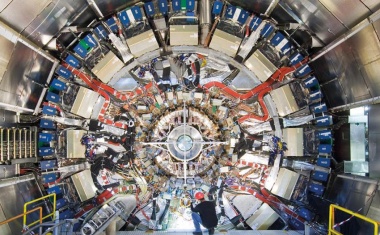

Auf den ersten Blick scheinen sich die Detektoren des Large Hadron Collider weitgehend zu ähneln: Wie Zwiebelschalen sind ATLAS, CMS, LHCb und ALICE um den Punkt herum aufgebaut, an dem die Teilchen kollidieren, und überdecken somit einen möglichst großen Teil des Raumwinkels. Welche Nachweiskonzepte stehen hinter diesen riesigen Detektoren? Worin unterscheiden sich ihre Ansätze, um den unterschiedlichen physikalischen Fragen, die sie beantworten sollen, gerecht zu werden?

Bei der Konzeption von Detektoren für einen Energiebereich, in dem „neue Physik“ erwartet wird, müssen sich die Teilchenphysiker zwangsläufig auf Phänomene fokussieren, die zwar bisher unbekannt, innerhalb des Gebäudes der Teilchenphysik aber „denkbar“ sind. Die Herausforderung besteht darin, charakteristische Merkmale dieser Phänomene (die „Signaturen“) in den Produkten einer Teilchenkollision nachzuweisen, also im sichtbaren Ereignis im Detektor.

Die beiden Großexperimente ATLAS und CMS (siehe Überblick auf S. 28) wurden insbesondere darauf optimiert, in Ereignissen von Proton-Proton-Kollisionen höchster Energie Signaturen von Higgs-Bosonen oder supersymmetrischen Teilchen zu finden. Der Erzeugungsquerschnitt für Higgs-Bosonen wird zum Beispiel je nach dessen Masse zwischen 10 fb und 50 pb erwartet (1 b = 1 barn = 10–24 cm2). Dies ist 13 bis 9 Größenordnungen kleiner als der totale Wirkungsquerschnitt für inelastische Proton-Proton-Reaktionen bei 14 TeV von etwa 80 mb. Um trotzdem genügend Higgs-Ereignisse zu erzeugen, wurde die Luminosität des LHC so hoch wie möglich getrieben (siehe Artikel auf S. 33). Als Konsequenz kommt es jedes Mal, wenn sich die Protonenpakete alle 25 ns kreuzen, im Mittel zu 25 inelastischen Proton-Proton-Kollisionen, die zusammen pro Sekunde etwa 1011 nachzuweisende Teilchen erzeugen. Das ergibt eine Datenmenge von 50 000 Gigabyte pro Sekunde. Eine elektronische Aufzeichnung und Zwischenpufferung der rund 150 Millionen Auslesekanäle und ein ausgeklügeltes elektronisches Auswahlsystem (Trigger) ermöglichen es jedoch, die Datenmenge bereits vor der Speicherung um vier Größenordnungen zu reduzieren und dabei einen möglichst großen Teil der interessanten Ereignisse zu behalten. Dies bedeutet immer noch eine jährliche Datenmenge von einigen Millionen Gigabyte, die über das weltweite LHC-Computing-GRID [1] verteilt, verwaltet und analysiert wird. ...

• 4/2012 • Seite 51

• 4/2012 • Seite 51Liefert die elektroschwache Wechselwirkung bei höchsten Energien Überraschungen?

Neben der direkten Suche nach neuen physikalischen Phänomenen bei höchsten Energien erlaubt der Large Hadron Collider auch Präzisionsmessungen, mit denen sich die Vorhersagen des Standardmodells der Elementarteilchen genau überprüfen lassen. Mögliche Inkonsistenzen und Abweichungen der Messungen von den Vorhersagen können indirekte Hinweise auf bisher unentdeckte Effekte geben.

Eine Vielzahl von Messungen hat das Standardmodell der Teilchenphysik in den letzten Jahrzehnten mit beindruckender Präzision bestätigt. Dennoch wissen wir, dass diese Theorie unvollständig sein muss: Sie liefert weder Kandidaten für die im Universum nachgewiesene Dunkle Materie noch kann sie die Materie-Antimaterie-Asymmetrie unserer Welt erklären. Konzeptionelle Fragen, wie etwa die tiefere Ursache der beobachteten drei Generationen von Quarks und Leptonen, bleiben offen. Daher gilt das Standardmodell heute als eine Näherung einer umfassenderen Theorie, die mit neuen, an höheren Energieskalen beobachtbaren Phänomenen einhergehen sollte.

Zum Aufspüren dieser neuen Phänomene sind weitere Präzisionsmessungen essenziell. Sie dienen zum einen dazu, die noch ungenau bekannten Parameter des Standardmodells besser zu bestimmen, um präzisere Vorhersagen machen zu können. Zum anderen ermöglichen sie den Nachweis von theoretisch vorhergesagten Quantenfluktuationen. Diese Fluktuationen, zu denen im Rahmen der Unschärferelation kurzzeitig auch sehr schwere Teilchen beitragen, können Größen wie Teilchenmassen und Kopplungskonstanten, aber auch die Zerfallseigenschaften von Teilchen beeinflussen. Grundsätzlich gilt, dass Quantenkorrekturen höherer Ordnung, bei denen also eine größere Zahl an Teilchenkopplungen auftritt, gegenüber einfacheren Prozessen unterdrückt sind.

Die Messung der teilweise sehr kleinen Quanteneffekte erlaubt Rückschlüsse auf die Eigenschaften der in den Fluktuationen virtuell auftretenden Teilchen. So ließ sich die Masse des Top-Quarks aus präzisen Daten zum Z-Boson vorhersagen, noch bevor es gelang, das Top-Quark direkt nachzuweisen. Präzisionsmessungen unterstützen auch die Suche nach dem Higgs-Boson, da Quantenkorrekturen mit einem virtuellen Higgs-Boson die Massen schwerer Teilchen wie Top-Quark und W-Boson beeinflussen (Abb. 1). Daher schränken die experimentell bestimmten W- und Top-Massen die mögliche Higgs-Masse weiter ein. So deuten die am LEP2- bzw. Tevatron-Beschleuniger erzielten Ergebnisse auf eine kleine Higgs-Masse nahe der bisherigen Ausschlussgrenze von 114 GeV/c2 hin (Abb. 2) [1]. Für eine präzisere Aussage wäre es nötig, die W-Masse genauer zu kennen. Wird das Higgs-Boson direkt nachgewiesen, erlaubt der Vergleich von direkt und indirekt ermittelter Higgs-Masse einen wichtigen Konsistenztest des Standardmodells. ...

• 4/2012 • Seite 45

• 4/2012 • Seite 45Der LHC eröffnet gänzlich neue Bereiche höchster räumlicher Auflösung und Energiedichten für die genaue Untersuchung der starken Wechselwirkung.

In den letzten vier Jahrzehnten haben zahlreiche Experimente Vorhersagen der Quantenchromodynamik (QCD), der Theorie der starken Wechselwirkung, bestätigt. Bereits die ersten Daten des LHC ermöglichen weitere Tests bei bisher unerreichten Impulsüberträgen und Energien, die die QCD in beeindruckender Weise bestanden hat.

Nach heutiger Kenntnis sind die durch die starke Wechselwirkung in Kernen der Größenordnung 10–14 m gebundenen Protonen und Neutronen (Nukleonen), ebenso wie alle anderen stark wechselwirkenden Teilchen (Hadronen), wiederum zusammengesetzt aus noch kleineren Konstituenten, den auch Partonen genannten Quarks und Gluonen. Die als punktförmig betrachteten Partonen tragen Farbladungen, deren starke Wechselwirkung sich mithilfe der Quantenchromodynamik beschreiben lässt. Besonderheiten der QCD sind das „Confinement“ sowie die „asymptotische Freiheit“ [1]. Ersteres besagt, dass alle Quarks und Gluonen in Hadronen eingesperrt bleiben und nicht als freie Teilchen nachweisbar sind. Ursache dafür ist die Stärke der Wechselwirkung, die zu großen Abständen hin sogar noch anwächst. Im Kontrast dazu beschreibt die asymptotische Freiheit die Beobachtung, dass sich die Partonen innerhalb eines Teilchens als quasifrei ansehen lassen, wenn man die Struktur der Hadronen mit hoher Auflösung untersucht. Je größer der Impulsübertrag in der Reaktion, der sich aus den Transversalimpulsen der erzeugten Teilchen relativ zur Strahlrichtung bestimmen lässt, desto höher ist die erreichte Auflösung und desto tiefer der Einblick in die Struktur des Protons.

Ereignisse mit den höchsten Transversalimpulsen entsprechen einer Auflösung von rund 10–19 m (Abb. 1).

Aufgrund der asymptotischen Freiheit lässt sich die Dynamik der Partonen bei kleinsten Abständen bzw. größten Impulsüberträgen mit dem mächtigen Werkzeug der Störungsrechnung in der starken Kopplungskonstanten αs theoretisch behandeln (perturbative QCD oder pQCD). Damit man auf diese Weise den Wirkungsquerschnitt einer unelastischen Proton-Proton-Streuung berechnen kann, also die auf eine Streureaktion bezogene Wahrscheinlichkeit für die Wechselwirkung zweier Protonen, ist es allerdings unerlässlich zu wissen, wie die Partonen in den kollidierenden Protonen verteilt sind (Abb. 2). Diese Partondichten lassen sich bisher zwar nicht ab initio berechnen, aber im Experiment bestimmen, z. B. bei HERA mit Hilfe der Elektron-Proton-Streuung [3]. Dank der experimentell gut überprüften Annahme, dass die Partonverteilungen nicht von der speziellen Teilchenreaktion abhängen, erlaubt die QCD dann präzise Vorhersagen für die Wirkungsquerschnitte der Proton-Proton-Streuung (pp) am LHC. ...

• 4/2012 • Seite 33

• 4/2012 • Seite 33Zahlreiche technologische Fortschritte waren notwendig, um den LHC zu realisieren.

Der Large Hadron Collider ist die größte und eine der komplexesten Maschinen, die der Mensch je gebaut hat. Er markiert den bisherigen Höhepunkt einer Reihe von Beschleunigern, die Ingenieure und Physiker erdacht haben, um die Struktur der subnuklearen Materie zu erkunden. Zahlreiche technische Innovationen waren nötig, um den LHC zu realisieren und zu bislang unerreichten Energien vorzudringen.

Ein Collider ist eine Maschine, die zwei Teilchenstrahlen auf hohe Energien beschleunigt und in speziellen Detektoren zur Kollision bringt. Beim LHC können die Hadronenstrahlen aus Protonen oder Ionen (z. B. Blei) bestehen. Die (Weiter-)Entwicklung zahlreicher innovativer Konzepte und Technologien erlaubt es, Kollisionsereignisse mit hoher Rate im Energiebereich vieler Tera-Elektronenvolt zu erzeugen – näher an den Bedingungen des Urknalls als je zuvor [1]. Um einen Eindruck von der gewaltigen Energie zu geben: Ein Elektronenvolt (eV) ist die Energie, die ein Elektron nach Durchlaufen einer 1 m langen Beschleunigungsspannung von 1 V/m erreicht. Der Protonenenergie von 1 TeV entspricht demnach eine 1000 km lange Strecke mit einer Beschleunigungsspannung von 1 M/m.

Schon 1977 kam während der Entwicklung des Large Electron Positron (LEP) Colliders die Idee auf, in dem 26,6 km langen Beschleunigertunnel nach Abschluss des LEP-Betriebs einen Collider für Hadronen zu bauen. Die CERN-Mitgliedsstaaten bewilligten das LHC-Projekt 1994 und führten es in den Folgejahren mit internationalen Beiträgen aus Japan, Kanada und den USA aus. Weitere Länder wie China, Indien oder Russland haben ebenfalls dazu beigetragen.

Der LHC besteht aus zwei unabhängigen, nebeneinanderliegenden Vakuumröhren, die im Mittel 100 Meter unter der Erdoberfläche im Beschleunigertunnel installiert sind (Abb. 1) [2]. Das benötigte, kontinuierliche Vakuumsystem mit einem Druck von unter 10−9 mbar ist eine der vielen technologischen Meisterleistungen am LHC. Die beiden kreisförmigen Ringe speichern zwei gegenläufige Teilchenstrahlen, die jeder mit über 99,99979 % der Lichtgeschwindigkeit etwa 11 000 Mal pro Sekunde umlaufen. ...

• 4/2012 • Seite 28

• 4/2012 • Seite 28Der Large Hadron Collider (LHC) ermöglicht Schlüsselexperimente zum Verständnis von Kräften und Materie.

Seit März 2010 kollidieren am Large Hadron Collider am europäischen Forschungszentrum CERN in Genf Protonen miteinander – bei den höchsten bislang in Beschleunigerlabors erzielten Energien. Damit erreicht die Teilchenphysik erstmals die TeV-Energieskala, auf der richtungsweisende Entdeckungen zu erwarten sind.

Ein Blick in die Wissenschaftsseiten der Zeitungen erweckt leicht den Eindruck, die Suche nach dem Higgs-Teilchen wäre die zentrale und einzige Aufgabe des Large Hadron Collider – insbesondere nachdem die Panikmache vor winzigen Schwarzen Löchern aus der Presse verschwunden ist. Doch der Eindruck trügt: Sicherlich ist die Untersuchung der Symmetriebrechung der schwachen Wechselwirkung – und damit verbunden die Suche nach dem Higgs-Teilchen – ein zentraler Punkt, aber die Aufgaben des LHC sind weitaus vielfältiger.

Obwohl der LHC erst auf einen Betrieb von etwa zwei Jahren zurückblicken kann, sind die Fülle und hohe Qualität der durchgeführten Messungen beeindruckend. Sowohl der Beschleuniger als auch die Detektoren haben ihre hervorragende Leistungsfähigkeit unter Beweis gestellt. Der Beschleuniger hat 2011 mehr Daten geliefert, als die Forscher sich erträumt hatten. Die Daten wurden hocheffizient aufgezeichnet und zeitnah analysiert. Die beiden großen Kollaborationen, ATLAS und CMS, haben jeweils mehr als 100 Artikel in referierten Zeitschriften publiziert. Auch das soziologische Experiment – die erfolgreiche Zusammenarbeit von mehreren Tausend Wissenschaftlern – ist offenbar gelungen.

Der LHC ist das größte Projekt der Elementarteilchenphysik. Der Beschleuniger wurde in rund 12 Jahren vom CERN unter Beteiligung von Industriepartnern gebaut. Supraleitende Magnete erzeugen eine Feldstärke von etwa 8,3 Tesla und halten damit die hochenergetischen Protonen auf der etwa 27 km langen Kreisbahn. Damit ist der LHC auch die größte supraleitende Anlage der Welt. ...

• 5/2011 • Seite 25

• 5/2011 • Seite 25Das Grid Computing ist für die Datenanalyse der LHC-Experimente unentbehrlich.

Mit dem Start des regulären Betriebs des Large Hadron Collider (LHC) am CERN begann für die Teilchenphysik eine neue Ära. In dieser sollen sich zentrale Fragen klären wie die nach dem Ursprung der Masse oder nach der theoretisch vermuteten Supersymmetrie zwischen Fermionen und Bosonen. Die beteiligten Physiker haben sich aber auch auf vielerlei Szenarien neuer Physik jenseits des bisher äußerst erfolgreichen Standardmodells der Teilchenphysik vorbereitet. Das Rückgrat für die Datenauswertung der Experimente bildet ein globales Netzwerk von mehreren hundert Rechenzentren, das „Worldwide LHC Computing Grid“.

Nach jahrzehntelangen Aufbauarbeiten des LHC und der Detektoren ALICE, ATLAS, CMS und LHCb konnten am 10. September 2008 alle Experimente erstmals Strahlreaktionen der Protonen im LHC bei einer Injektionsenergie von 450 GeV aufzeichnen. Während der mehr als einjährigen Reparaturphase nach einer technische Panne im September 2008 gelang es, Milliarden Ereignisse aus der kosmischen Strahlung zu registrieren und damit eine erste Eichung der Detektorkomponenten vorzunehmen. Die Zeit diente insbesondere auch dazu, die Verteilung und Auswertung der Daten innerhalb des Computer-Netzwerks der am LHC beteiligten Institute unter realistischen Bedingungen zu erproben und zu verbessern. Bei der Wiederinbetriebnahme Ende 2009 löste der LHC mit dem Erreichen einer Schwerpunktsenergie von 2,36 TeV schließlich das Tevatron als weltweit leistungsstärksten Beschleuniger ab. Nach einer kurzen Winterpause lief der LHC dann ab dem 30. März 2010 im regulären Betrieb bei einer Schwerpunktsenergie von 7 TeV. ...

• 1/2011 • Seite 23

• 1/2011 • Seite 23Wie Höchstleistungscomputer mit handelsüblichen PC-Grafikkarten noch schneller rechnen

In vielen Bereichen der modernen Physik wächst der Bedarf an Computerleistung stetig. Oft sind mehr als eine Billiarde Rechenoperationen pro Sekunde nötig, um die Datenmassen zu erfassen und auszuwerten oder komplexe physikalische Prozesse zu simulieren. Höchstleistungscomputer verschlingen immer größere Summen und verursachen immense Betriebskosten, schon allein durch ihren Energiebedarf. Doch handelsübliche Grafikkarten, wie sie sich in PCs finden, bieten hier besonders interessante Alternativen.

Welche Bedeutung Höchstleistungscomputer für die Forschung haben, macht die Hoch-energiephysik besonders deutlich. Dort gilt es, zunehmend komplexere Detektorsysteme mit immer mehr Sensoren immer schneller auszulesen. Sowohl die Rate der aufgezeichneten Ereignisse als auch die Anzahl der zu messenden Teilchen pro Ereignis steigen. Beim Large Electron-Positron Collider (LEP), dem Vorgänger des Large Hadron Colliders (LHC) am CERN fanden in der Regel noch weniger als hundert Ereignisse pro Sekunde statt, und jedes Ereignis umfasste rund 100 Kilobyte an Daten. Die Daten ließen sich im Wesentlichen nach der Aufzeichnung auswerten. Mit jeder neuen Generation von Detektoren ist die Anforderung an die Computer-Infrastruktur um mehr als eine Größenordnung gestiegen. ...

• 10/2008 • Seite 20

• 10/2008 • Seite 20Interview mit dem designierten Generaldirektor des CERN, Rolf-Dieter Heuer

Nach einer Bauzeit von acht Jahren ging in diesem Herbst der drei Milliarden Euro teure Large Hadron Collider (LHC) am europäischen Zentrum für Teilchenphysik CERN in Genf in Betrieb. Wenige Wochen später, im Januar 2009, beginnt die fünfjährige Amtszeit von Rolf-Dieter Heuer als Generaldirektor des CERN – der zweite Deutsche in diesem Amt. Ende August sprach Stefan Jorda mit dem experimentellen Teilchenphysiker in Genf.

In wenigen Wochen fällt der Startschuss für den LHC, und kurz danach beginnt Ihre Amtszeit als Generaldirektor. Wie ist Ihr Gemütszustand?

Gut. Ein kleines bisschen aufgeregt und voller Vorfreude. Nicht angespannt, sondern gespannt.

Ist das auch die allgemeine Stimmung hier am CERN?

Mit Sicherheit. Wir legen jetzt einen Sprint hin am Schluss eines Marathonlaufs, hat jemand gesagt.

Was heißt es, den LHC in Betrieb zu nehmen? Da wird ja nicht ein Schalter umgelegt, und die Maschine läuft …

Genau. Da gibt es viele Teilschritte. Die Vorbeschleuniger des LHC sind bereits alle getestet, auch der erste Einschuss in den Collider. Alles muss fein aufeinander abgestimmt sein, die Steuerung der Magnete, das ganze Timing, bevor am 10. September der Strahl mit der Einschussenergie vom SPS einmal im Kreis herum laufen soll. Wenn beide gegenläufigen Strahlen durchgefädelt sind, werden wir die Energie langsam hoch fahren und die Strahlen zur Kollision bringen – ich hoffe, dass dies am 21. Oktober, dem Tag der offiziellen Einweihung, erstmals der Fall sein wird. Danach starten die Messungen, allerdings

mit niedrigem Strahlstrom.

Wie funktioniert die Inbetriebnahme der Detektoren?

Der Knackpunkt wird sein, die Detektoren wirklich zu verstehen.

Am 10. September hat der Large Hadron Collider am Forschungszentrum CERN in Genf erfolgreich seinen Betrieb aufgenommen.

• 3/2007 • Seite 25

• 3/2007 • Seite 25Bis zu 2000 Physikerinnen und Physiker entwickeln und bauen die Detektoren des Large Hadron Colliders. Die Kollaborationen haben sich sehr demokratische Spielregeln gegeben.

Ohne Helm geht gar nichts. Nicht erst seit einem Unfall im vorletzten Jahr wird Sicherheit ganz groß geschrieben am Europäischen Zentrum für Teilchenphysik CERN in Genf. Vorschriftsmäßig mit Helm auf dem Kopf geht es von einer schmucklosen Halle aus mit dem Fahrstuhl rund 100 Meter tief unter die Erde. Wenige Sekunden später ist eine Kaverne erreicht, in der locker ein Mehrfamilienhaus Platz hätte. Hier sollen schon bald einige Rätsel des Universums gelöst werden. Wie kommt die Masse in die Welt? Existiert das Higgs-Boson, dessen Existenz eigens dafür vor 30 Jahren postuliert wurde? Lassen sich mithilfe der Supersymmetrie drei der bekannten Kräfte vereinigen? In welchem Zustand befand sich das Universum unmittelbar nach dem Urknall? Der ATLAS-Detektor, der in der Kaverne entsteht, soll gemeinsam mit den anderen drei Detektoren am LHC-Beschleuniger (Large Hadron Collider) Antworten auf diese und andere fundamentale Fragen liefern. Der dazu notwendige Aufwand ist gigantisch: Bei einem Durchmesser von 24 Metern und einer Länge von 46 Metern wird ATLAS rund 7000 Tonnen wiegen.

Auch der 27 Kilometer lange LHC selbst geizt nicht mit Superlativen. ...

Diese Webseite für das breite Publikum gibt einen Überblick über den Beschleuniger, die Detektoren sowie die wissenschaftlichen Fragen, die die Experimente beantworten sollen.

Diese Seite der deutschen Teilchenphysiker beantwortet viele Fragen rund um den LHC.

Ein ebenso umfasssender wie zugänglicher Überblick über die Physik und experimentellen Techniken bei höchsten Energien, speziell am Large Hadron Collider, geschrieben aktiven Forschern auf diesem Gebiet.