Autonomes Fahren mit Voraussicht

Lidar-System mit selbstlernendem Algorithmus für die semantische Interpretation von Fahrsituationen.

Gute Autofahrer sehen gefährliche Situationen voraus und stellen ihre Fahrweise darauf ein, bevor es wirklich brenzlig wird. Forscher der Universität Bonn wollen diese Fähigkeit nun auch autonomen Autos beibringen. Am Freitag, 1. November, stellen sie auf der International Conference on Computer Vision in Seoul einen entsprechenden Algorithmus vor. Außerdem präsentieren sie einen Datensatz, mit dem sie ihren Ansatz trainiert und getestet haben. Er wird es in Zukunft erheblich einfacher machen, derartige Verfahren zu entwickeln und zu verbessern.

Eine leere Straße, am Rand eine Reihe parkender Autos: Nichts, was zur Vorsicht mahnen würde. Doch halt: Mündet nicht da vorne, halb verdeckt von den parkenden Wagen, eine Straße ein? Vielleicht nehme ich doch lieber den Fuß vom Gas – wer weiß, ob da jemand von der Seite kommt. Beim Autofahren begegnen wir ständig Situationen wie diesen. Sie korrekt zu deuten und die richtigen Konsequenzen zu ziehen, erfordert eine Menge Erfahrung. Demgegenüber verhalten sich selbstfahrende Autos mitunter wie ein Fahrschüler in seiner ersten Stunde. „Unser Ziel ist es, ihnen eine vorausschauendere Fahrweise beizubringen“, erklärt der Informatiker Jürgen Gall. „Sie könnten dann erheblich schneller auf gefährliche Situationen reagieren.“

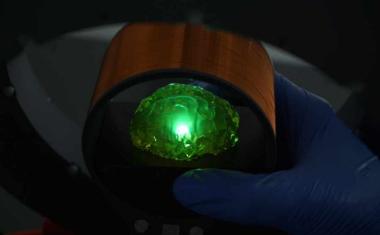

Gall leitet an der Universität Bonn die Arbeitsgruppe „Computer Vision“, die in Kooperation mit dem Institut für Photogrammetrie und der Arbeitsgruppe „Autonome Intelligente Systeme“ an der Lösung dieses Problems forscht. Auf der führenden Fachtagung seiner Zunft, der International Conference on Computer Vision in Seoul, stellen die Wissenschaftler nun einen ersten Schritt auf dem Weg zu diesem Ziel vor. „Wir haben einen Algorithmus weiterentwickelt, der Lidar-Daten vervollständigt und interpretiert“, erklärt er. „Das Auto kann sich dadurch auf mögliche Gefahren frühzeitig einstellen.“

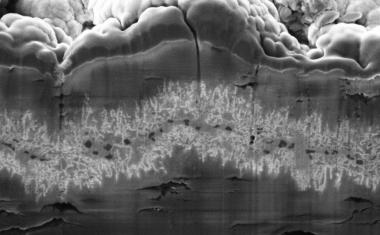

Bei Lidar handelt es sich um einen rotierenden Laser, der auf dem Dach der meisten autonom fahrenden Autos angebracht ist. Der Laserstrahl wird von der Umgebung reflektiert. Das Lidar-System misst, wann das reflektierte Licht auf den Sensor fällt, und berechnet aus der Laufzeit die Entfernung. „Pro Umdrehung erfasst das System auf diese Weise die Distanz zu rund 120.000 Punkten rund um das Fahrzeug“, sagt Gall.

Das Problem dabei: Die Messpunkte „verdünnen“ sich mit steigender Entfernung – ihr Abstand untereinander nimmt zu. Selbst für einen Menschen ist es daher kaum möglich, sich aus einem einzelnen Lidar-Scan (also den Entfernungsmessungen einer einzigen Umdrehung) ein korrektes Bild seiner Umgebung zu verschaffen. „Die Universität Karlsruhe (KIT) hat vor einigen Jahren große Mengen von Lidar-Daten aufgenommen, insgesamt 43.000 Scans“, erklärt Jens Behley vom Institut für Photogrammetrie. „Wir haben nun jeweils Sequenzen von mehreren Dutzend Scans genommen und diese überlagert.“ Die so gewonnenen Daten enthalten also auch Punkte, die der Sensor erst erfasst hatte, als das Auto schon einige Dutzend Meter weiter gefahren war. Vereinfacht gesagt, zeigen sie nicht nur die Gegenwart, sondern auch die Zukunft.

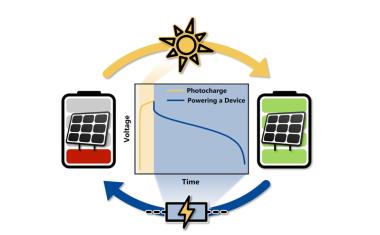

„Diese überlagerten Punktwolken enthalten wichtige Informationen wie die Geometrie der Szene und die räumliche Ausdehnung der darin enthaltenen Objekte, die in einem einzelnen Scan nicht verfügbar sind“, betont Martin Garbade, der momentan am Institut für Informatik promoviert. „Zusätzlich haben wir in ihnen jeden einzelnen Punkt beschriftet – also etwa: Dort ist ein Gehweg, da ein Fußgänger und dahinten ein Motorradfahrer.“ Die Wissenschaftler fütterten ihre Software mit einem Datenpaar: einem einzelnen Lidar-Scan als Eingabe sowie den dazu gehörigen Überlagerungsdaten samt semantischer Information als gewünschte Ausgabe. Das wiederholten sie für mehrere tausend solcher Paare.

„In dieser Trainingsphase lernte der Algorithmus, einzelne Scans zu vervollständigen und zu interpretieren“, erklärt Gall. „Er konnte danach also fehlende Messwerte plausibel ergänzen und interpretieren, was in den Scans zu sehen war.“ Die Szenen-Komplettierung funktioniert bereits relativ gut: Rund die Hälfte der fehlenden Daten kann das Verfahren korrekt vervollständigen. Nicht ganz so gut klappt es mit der semantischen Interpretation – also der Schlussfolgerung, welche Objekte sich hinter den Messpunkten verbergen: Hier kommt der Rechner auf eine Trefferquote von maximal 18 Prozent.

Allerdings sehen die Wissenschaftler diesen Forschungszweig noch ganz am Anfang. „Bislang fehlte es schlicht an umfangreichen Datensätzen, mit denen sich entsprechende Verfahren aus der künstlichen Intelligenz trainieren lassen“, betont Gall. „Wir schließen hier mit unserer Arbeit eine Lücke. Ich bin optimistisch, dass wir in den nächsten Jahren die Trefferquote bei der semantischen Interpretation deutlich steigern können.“ Fünfzig Prozent hält er für durchaus realistisch, was einen enormen Einfluss auf die Qualität des autonomen Fahrens haben könnte.

U. Bonn / DE

Weitere Infos

- Originalveröffentlichung

J. Behley et al.: SemanticKITTI: A Dataset for Semantic Scene Understanding of LiDAR Sequences, IEEE/CVF International Conference on Computer Vision; Preprint: arXiv:1904.01416 [cs.CV] - Projekt SemanticKITTI, Universität Bonn